在服务器扩展性规划中,数据一致性和负载均衡是确保系统性能和可靠性的关键因素。本文将探讨如何有效地处理这两个问题,以支持系统的高可用性和高效能。首先,文章介绍了数据一致性的挑战,并提供了解决方案,包括分布式数据库和一致性协议。接着,探讨了负载均衡的策略与技术,如轮询、最少连接和自适应负载均衡。最后,文章总结了这两者之间的关系以及如何综合考虑以优化系统性能。

一、引言

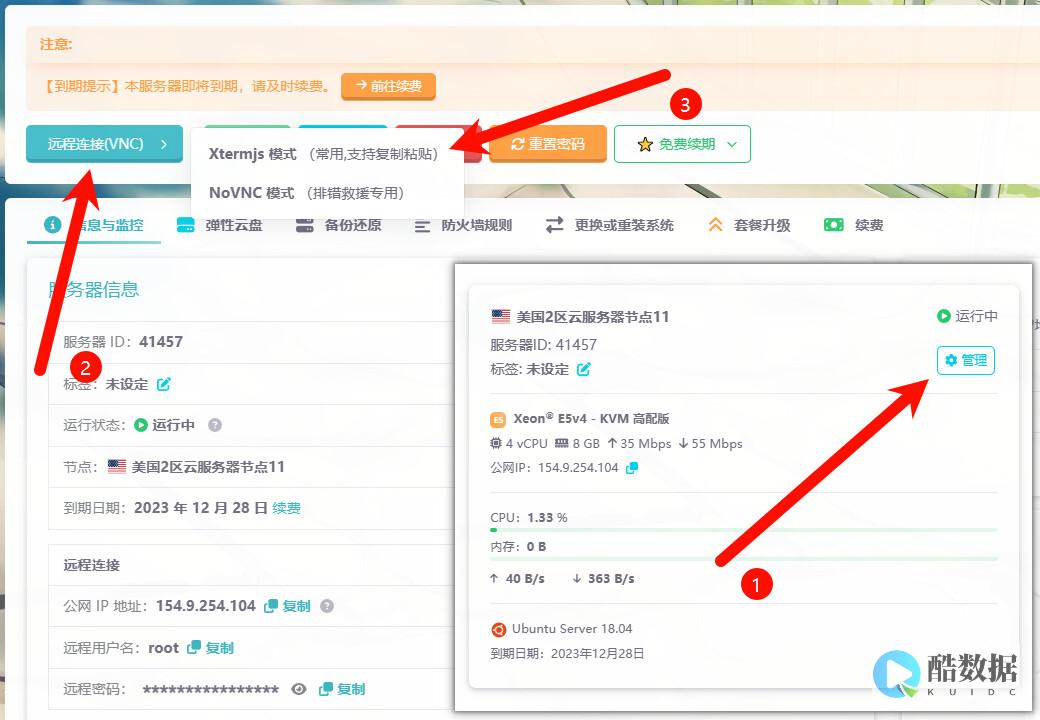

在现代IT环境中,服务器扩展性规划对于应对不断增长的用户需求至关重要。数据一致性和负载均衡是扩展性规划中的两个核心问题。数据一致性确保所有服务器上的数据状态保持同步,而负载均衡则旨在优化资源使用,避免任何单一服务器过载。本文将深入探讨如何在扩展过程中有效地处理这两个问题,确保系统的稳定性和高效性。

二、数据一致性挑战及解决方案

数据一致性的定义与挑战

数据一致性指的是在分布式系统中,所有副本在任何时间点都应保持相同的数据状态。挑战在于网络延迟、分区故障和并发操作可能导致数据不一致。这需要系统具备处理这些问题的能力,以确保数据在所有节点上的一致性。

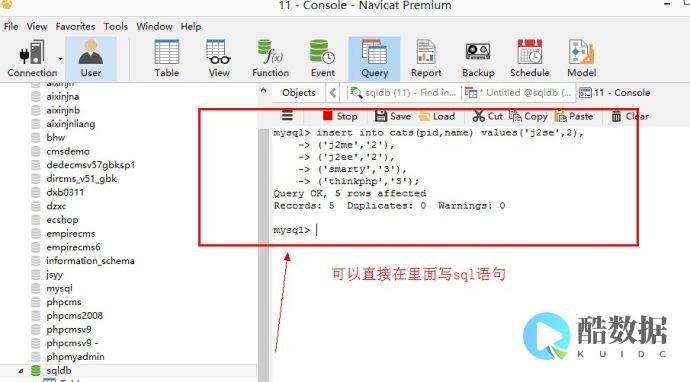

分布式数据库解决方案

分布式数据库系统(如Cassandra和MongoDB)通过数据复制和分区来实现高可用性和一致性。这些系统通常采用“最终一致性”模型,确保所有节点在一段时间内达到一致状态。根据应用的需求,可以选择不同的一致性策略,如强一致性或最终一致性。

一致性协议

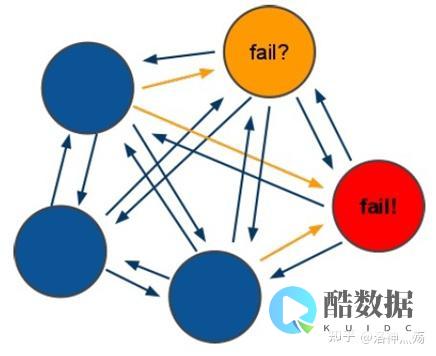

一致性协议(如Paxos和Raft)用于协调分布式系统中的多个节点,以达成一致决策。这些协议通过解决节点之间的通信和同步问题,确保系统在面对节点失败或网络分区时,仍能维持数据的一致性。

三、负载均衡策略与技术

负载均衡的目标与重要性

负载均衡旨在将用户请求均匀地分配到多个服务器上,以避免单点过载,并提高系统的响应时间和可用性。有效的负载均衡策略可以显著提升系统的性能和用户体验。

负载均衡策略

轮询(Round Robin): 通过顺序分配请求到各个服务器,适用于请求负载均衡均匀的场景。

最少连接(Least Connections): 将请求分配给当前连接数最少的服务器,适合处理负载变化大的情况。

自适应负载均衡(Adaptive Load Balancing): 动态调整请求分配,根据服务器的实时性能指标做出决策,以提高负载均衡的精确度。

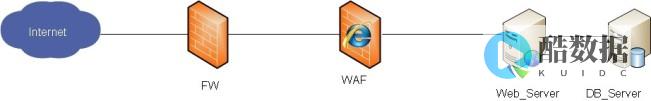

负载均衡技术

硬件负载均衡器: 专用设备,通常提供高性能和丰富的功能,但成本较高。

软件负载均衡器: 如Nginx和HAProxy,具有灵活性和扩展性,适合多种应用场景。

云负载均衡服务: 如AWS ELB和Azure Load Balancer,提供托管服务,简化配置和管理。

四、综合考虑数据一致性与负载均衡

关系与冲突

在处理数据一致性和负载均衡时,需要平衡两者之间的冲突。负载均衡可能导致数据请求被分配到不同的服务器上,增加了数据一致性的挑战。因此,设计时需要考虑如何在负载均衡的同时,维护数据一致性。

协调策略

实现高效的负载均衡时,可以采用一致性哈希算法,减少数据移动带来的负担。同时,合理配置负载均衡策略,配合一致性协议,确保系统在扩展过程中既能维持数据一致性,又能优化负载分配。

五、结论

在服务器扩展性规划中,数据一致性和负载均衡是确保系统性能和稳定性的关键因素。通过有效地采用分布式数据库、一致性协议和负载均衡技术,可以在扩展过程中处理好这两个问题。综合考虑这两者之间的关系,并合理设计系统架构,有助于实现高可用、高效能的服务器环境。随着技术的发展,未来的扩展性规划将需要不断优化这些策略,以应对不断变化的需求和挑战。

好主机测评广告位招租-300元/3月nginx实现Tomcat集群的负载均衡有几种方式

一,如果仅是对外提供一个页面访问,不用区分单一用户(不区分每个访问session,不涉及用户权限,用户资料等内容),仅仅配置nginx负载均衡策略即可。 nginx负载均衡策略主要分一下四种:1)、轮询(默认)每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器宕机,能自动剔除。 2)、ip_hash 每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器。 3)、fair 按后端服务器的响应时间来分配请求,响应时间短的优先分配。 4)、url_hash 按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,后端服务器为缓存时比较有效。 二,如果涉及到用户session,做一些鉴权缓存、存放临时信息时,就必须做tomcat的session共享。 目前可参考到的session共享方式主要分为两种。 1)利用tomcat自带的组播机制,实现session复制。 对tomcat及应用的若干配置文件进行配置即可实现,网上有很多资料可参考。 但这种方式些弊端,看过一些资料,不建议用session复制的方式。 在实际使用过程中,也发现有存在session莫名失踪的现象。 2)利用第三方机制存储session。 比较常见的是tomcat集成memcached服务器来存储session。 实际项目中,我们采用过利用redis实现session存储,redis高效的存取性能为高效的访问提供了保障,但是目前redis的集群功能似乎没有发布,如何解决redis的单点故障需要研究。

Oracle多个服务各代表什么作用

这个服务会自动地启动和停止数据库。 如果安装了一个数据库,它的缺省启动类型为自动。 服务进程为,参数文件,日志文件,控制台、。

hadoop的优点有哪些 a处理超大文件 b低延迟访问数据

一、 Hadoop 特点 1、支持超大文件 一般来说,HDFS存储的文件可以支持TB和PB级别的数据。 2、检测和快速应对硬件故障 在集群环境中,硬件故障是常见性问题。 因为有上千台服务器连在一起,故障率高,因此故障检测和自动恢复hdfs文件系统的一个设计目标。 假设某一个datanode节点挂掉之后,因为数据备份,还可以从其他节点里找到。 namenode通过心跳机制来检测datanode是否还存在 3、流式数据访问 HDFS的数据处理规模比较大,应用一次需要大量的数据,同时这些应用一般都是批量处理,而不是用户交互式处理,应用程序能以流的形式访问数据库。 主要的是数据的吞吐量,而不是访问速度。 访问速度最终是要受制于网络和磁盘的速度,机器节点再多,也不能突破物理的局限,HDFS不适合于低延迟的数据访问,HDFS的是高吞吐量。 4、简化的一致性模型 对于外部使用用户,不需要了解hadoop底层细节,比如文件的切块,文件的存储,节点的管理。 一个文件存储在HDFS上后,适合一次写入,多次写出的场景once-write-read-many。 因为存储在HDFS上的文件都是超大文件,当上传完这个文件到hadoop集群后,会进行文件切块,分发,复制等操作。 如果文件被修改,会导致重新出发这个过程,而这个过程耗时是最长的。 所以在hadoop里,不允许对上传到HDFS上文件做修改(随机写),在2.0版本时可以在后面追加数据。 但不建议。 5、高容错性 数据自动保存多个副本,副本丢失后自动恢复。 可构建在廉价机上,实现线性(横向)扩展,当集群增加新节点之后,namenode也可以感知,将数据分发和备份到相应的节点上。 6、商用硬件 Hadoop并不需要运行在昂贵且高可靠的硬件上,它是设计运行在商用硬件的集群上的,因此至少对于庞大的集群来说,节点故障的几率还是非常高的。 HDFS遇到上述故障时,被设计成能够继续运行且不让用户察觉到明显的中断。 二、HDFS缺点 1、不能做到低延迟 由于hadoop针对高数据吞吐量做了优化,牺牲了获取数据的延迟,所以对于低延迟数据访问,不适合hadoop,对于低延迟的访问需求,HBase是更好的选择, 2、不适合大量的小文件存储 由于namenode将文件系统的元数据存储在内存中,因此该文件系统所能存储的文件总数受限于namenode的内存容量,根据经验,每个文件、目录和数据块的存储信息大约占150字节。 因此,如果大量的小文件存储,每个小文件会占一个数据块,会使用大量的内存,有可能超过当前硬件的能力。 3、不适合多用户写入文件,修改文件 Hadoop2.0虽然支持文件的追加功能,但是还是不建议对HDFS上的 文件进行修改,因为效率低。 对于上传到HDFS上的文件,不支持修改文件,HDFS适合一次写入,多次读取的场景。 HDFS不支持多用户同时执行写操作,即同一时间,只能有一个用户执行写操作。

发表评论